AI (人工智能),LLM (大语言模型),CPU 和 GPU 区别:你了解吗?

✅ 感知(Perception)

通过传感器、摄像头、麦克风等获取数据(如计算机视觉、语音识别)。例子:人脸识别(Face ID)、语音助手(Siri/Alexa)。✅ 学习(Learning)

从数据中自动提取规律,无需显式编程。主要方法:机器学习(ML)、深度学习(DL)。✅ 推理与决策(Reasoning & Decision-Making)

基于逻辑或概率进行判断(如自动驾驶避障、医疗诊断)。例子:AlphaGo 下围棋、ChatGPT 生成文本。✅ 自适应(Adaptation)

根据环境变化调整行为(如推荐系统优化、机器人路径规划)。2. AI 的主要类型(1) 按能力分类类型

描述

例子

ANI(狭义 AI)

专注于单一任务,无法超越设定范围

人脸识别、垃圾邮件过滤

AGI(通用 AI)

像人类一样广泛思考、学习、解决任何问题(尚未实现)

科幻中的“机器人”(如《终结者》)

ASI(超级 AI)

智力远超人类,可能具备自我意识(理论设想)

《2001太空漫游》的 HAL 9000

(2) 按技术分类类型

关键方法

应用场景

机器学习(ML)

从数据中学习模式(监督学习、无监督学习、强化学习)

金融风控、推荐系统

深度学习(DL)

基于神经网络的机器学习(CNN、RNN、Transformer)

图像识别、自然语言处理(NLP)

强化学习(RL)

通过试错优化决策(如游戏 AI、机器人控制)

AlphaGo、自动驾驶

3. AI 的典型应用️ 计算机视觉(CV)

人脸识别、医学影像分析、自动驾驶感知。️ 自然语言处理(NLP)

机器翻译(Google Translate)、聊天机器人(ChatGPT)、语音合成。机器人技术(Robotics)

工业机器人、服务机器人(如波士顿动力 Atlas)。数据分析与预测

股票预测、广告精准投放、疫情传播建模。4. AI 的底层依赖 数据:海量高质量数据是训练 AI 的基础(如 ImageNet 用于图像识别)。

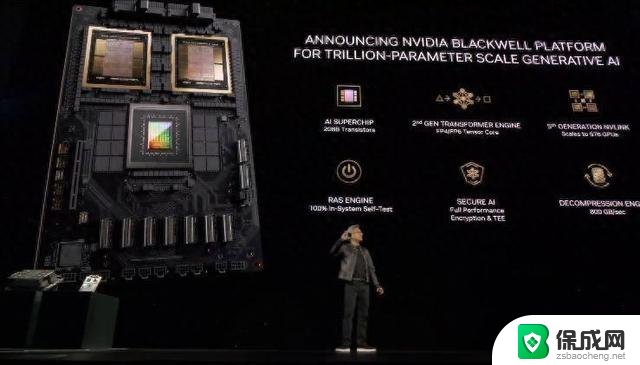

算力:GPU/TPU 加速训练(如 NVIDIA A100 跑深度学习)。

算法:神经网络架构创新(如 Transformer 推动 GPT 发展)。

大模型(LLM):如 GPT-4、Claude 3 推动通用 AI 发展。

AI + 物联网(AIoT):智能家居、智慧城市。

⚕️ AI 医疗:辅助诊断、药物研发。

⚠️ 伦理与安全:AI 偏见、深度伪造(Deepfake)、自主武器。

AI 是让机器模拟人类智能的技术,涵盖感知、学习、决策等能力,依赖数据、算力和算法。当前以 ANI(弱 AI) 为主,AGI(强 AI) 仍是长期目标。应用遍及医疗、金融、自动驾驶等领域,但也面临伦理挑战。未来,AI 可能重塑社会,但需谨慎发展。

LLM(Large Language Model,大语言模型)详解LLM 是一种基于海量文本数据训练的深度学习模型,能够理解、生成和推理自然语言。它属于生成式 AI(Generative AI),核心架构通常基于 Transformer(如 GPT、PaLM、LLaMA)。

LLM (大语言模型)1. LLM 的核心特点✅ 大规模参数(通常 数十亿~万亿级)

例如:GPT-3 有 1750 亿参数,GPT-4 规模更大(未公开具体数字)。✅ 通用语言能力可处理翻译、问答、写作、代码生成等多种任务。

✅ 上下文学习(In-context Learning)无需微调,通过提示(Prompt)直接适应新任务(如 Few-shot Learning)。

✅ 涌现能力(Emergent Abilities)当模型规模超过临界点,突然表现出小模型没有的能力(如复杂推理)。2. LLM 的核心技术(1) 基础架构:Transformer依赖 自注意力机制(Self-Attention) 捕捉长距离语义关联。核心组件:编码器(Encoder):理解输入(如 BERT)。解码器(Decoder):生成输出(如 GPT)。(2) 训练流程预训练(Pre-training)目标:通过海量文本学习语言统计规律(如预测下一个词)。数据:互联网公开文本(书籍、网页、代码等)。硬件:依赖 GPU/TPU 集群(训练 GPT-3 需数千张 A100)。微调(Fine-tuning)用特定领域数据优化模型(如医疗、法律垂直场景)。方法:监督微调(SFT)、强化学习(RLHF,如 ChatGPT)。3. 主流 LLM 对比

模型

机构

参数量

特点

GPT-4

OpenAI

~1.8T*

多模态(支持图像输入)、推理强

Claude 3

Anthropic

未公开

长上下文(20万 token)、低幻觉

Gemini 1.5

~10T*

多模态、高效长文本处理

LLaMA 3

Meta

8B~70B

开源、轻量化

Mistral

Mistral AI

7B~8x7B

开源、高性能小模型

4. LLM 的应用场景 内容生成:写作辅助、营销文案、代码补全(GitHub Copilot)。

知识问答:替代搜索引擎(如 Perplexity AI)、教育辅导。

对话系统:智能客服(如 ChatGPT)、虚拟助手。

多语言任务:实时翻译、跨语言摘要。

⚙️ 垂直领域:法律合同分析、医疗报告生成。

⚠️ 幻觉(Hallucination):生成虚假信息(如编造论文引用)。

安全与伦理:生成恶意内容、隐私泄露(训练数据含敏感信息)。

高成本:训练 GPT-4 需数千万美元,推理耗算力。

局限性:

多模态融合:结合文本、图像、音频(如 GPT-4V)。

小型化与优化:降低推理成本(如量化、MoE 架构)。

️ 安全对齐(Alignment):减少偏见、提高可控性。

开源生态:LLaMA、Mistral 推动社区创新。

LLM 是当前 AI 最热门的技术之一,依靠 Transformer 和海量数据实现通用语言能力,但其本质仍是“高级统计模型”。未来将向更高效、更安全、多模态方向发展,同时需解决伦理与成本问题。

CPU 和 GPU 区别CPU(Central Processing Unit,中央处理器)和 GPU(Graphics Processing Unit,图形处理器)是计算机中两种重要的处理器,它们在设计目标和应用场景上有显著区别:

1. 设计目标不同CPU:强调通用计算,适合处理复杂、串行的任务(如操作系统、应用程序逻辑、数据库查询等)。核心少但单个核心强(现代 CPU 通常 4~32 核,但每个核心能高效处理分支预测、乱序执行等复杂逻辑)。延迟优化(快速响应单个任务)。GPU:专为并行计算设计,适合处理大量简单、重复的计算(如图形渲染、深度学习、科学计算等)。核心极多但单个核心较弱(例如 NVIDIA RTX 4090 有 16,384 个 CUDA 核心,但每个核心只做简单运算)。吞吐量优化(同时处理海量数据)。2. 架构差异特性

CPU

GPU

核心数量

较少(通常 4~32 核)

极多(数千~上万核心)

缓存

大缓存(L1/L2/L3)减少延迟

小缓存,依赖高带宽内存(HBM/GDDR)

线程管理

支持复杂多线程(如超线程)

超大规模线程并行(SIMT*架构)

适用场景

通用计算、控制密集型任务

数据并行计算(如图形、AI、挖矿)

3. 典型应用场景CPU:操作系统、Web 服务器、数据库、应用程序逻辑、单线程任务。GPU:图形渲染(游戏、3D 建模)AI/深度学习(训练神经网络,如 ChatGPT)科学计算(气候模拟、分子动力学)密码学/挖矿(如比特币早期挖矿)4. 协同工作(CPU + GPU)现代计算(如 AI、游戏引擎)通常采用 异构计算:

CPU 负责逻辑控制、任务调度。GPU 负责大规模并行计算(如渲染、矩阵运算)。例子:玩《赛博朋克 2077》时,CPU 处理物理引擎和 NPC AI,GPU 负责渲染画面。

总结对比项

CPU

GPU

核心目标

低延迟,复杂逻辑

高吞吐,并行计算

核心数量

少(但强大)

极多(但简单)

适用任务

通用计算

图形、AI、科学计算

简单说:

CPU 是“大学教授”——能处理各种复杂问题,但一次只能做几件事。GPU 是“小学生军团”——每人只会简单算术,但数万人一起算,速度碾压教授。如果需要深度计算(如训练 AI),GPU 比 CPU 快 10~100 倍;但如果是日常办公,CPU 更高效。